Fully translated (but some work to do about urls)

This commit is contained in:

@@ -1,22 +1,22 @@

|

||||

---

|

||||

navigation: true

|

||||

title: Scripts bash

|

||||

title: Bash Scripts

|

||||

main:

|

||||

fluid: false

|

||||

---

|

||||

:ellipsis{left=0px width=40rem top=10rem blur=140px}

|

||||

# Scripts bash

|

||||

# Bash Scripts

|

||||

|

||||

Quelques scripts en vracs qui m'ont sauvé la vie.

|

||||

A few random scripts that saved my life.

|

||||

|

||||

## Detection de doublons et remplacement par des hardlinks

|

||||

## Detecting Duplicates and Replacing Them with Hardlinks

|

||||

---

|

||||

|

||||

Six mois après avoir téléchargé des térabytes de media, je me suis rendu compte que Sonarr et Radarr les copaient dans ma biblio Plex au lieu de créer des hardlinks. C'est dû à un mécanisme contre intuitif qui est que si vous montez plusieurs dossiers dans Sonarr/Radarr, il les voit comme deux systemes de fichiers différents. Et ne peut donc pas créer de hardlinks. C'est pour cela qu'il ne faut monter qu'un seul dossier parent, qui contient tous les enfants (`downloads`, `movies`, `tvseries` dans le dossier parent `media` par exemple).

|

||||

Six months after downloading terabytes of media, I realized that Sonarr and Radarr were copying them into my Plex library instead of creating hardlinks. This happens due to a counterintuitive mechanism: if you mount multiple folders in Sonarr/Radarr, it sees them as different filesystems and thus cannot create hardlinks. That’s why you should mount only one parent folder containing all child folders (like `downloads`, `movies`, `tvseries` inside a `media` parent folder).

|

||||

|

||||

J'ai donc restructuré mes dossiers, remis à la main chaque chemin dans Qbittorrent, Plex, et autres. Il restait à trouver un moyen de détecter les doublons existants et d'automatiquement les supprimer et de créer des hardlinks à la place, pour économiser de l'espace.

|

||||

So I restructured my directories, manually updated every path in Qbittorrent, Plex, and others. The last challenge was finding a way to detect existing duplicates, delete them, and automatically create hardlinks instead—to save space.

|

||||

|

||||

Mes dossiers :

|

||||

My directory structure:

|

||||

|

||||

```console

|

||||

.

|

||||

@@ -28,84 +28,85 @@ Mes dossiers :

|

||||

└── tvseries

|

||||

```

|

||||

|

||||

Mes dossiers originaux sont dans `seedbox`, et il ne faut surtout pas les modifier pour qu'ils continuent d'etre "seed". Les copies, et donc doublons, sont dans `movies` et `tvseries`. Mais pour complexifier la chose, j'ai aussi des media uniques originaux déposés par ailleurs dans `movies` et `tvseries`, sinon cela serait trop facile. Et dans ces deux dossiers, il peut y avoir des sous dossiers, des sous-sous dossiers, etc.

|

||||

The originals are in `seedbox` and must not be modified to keep seeding. The copies (duplicates) are in `movies` and `tvseries`. To complicate things, there are also unique originals in `movies` and `tvseries`. And within those, there can be subfolders, sub-subfolders, etc.

|

||||

|

||||

L'idée est donc de :

|

||||

So the idea is to:

|

||||

|

||||

- lister les originaux dans seedbox

|

||||

- lister les fichiers dans movies

|

||||

- comparer les deux listes et isoler les chemins des doublons

|

||||

- supprimer les doublons

|

||||

- hardlinker les originaux dans les dossiers des doublons supprimés

|

||||

- list the originals in seedbox

|

||||

- list files in movies and tvseries

|

||||

- compare both lists and isolate duplicates

|

||||

- delete the duplicates

|

||||

- hardlink the originals to the deleted duplicate paths

|

||||

|

||||

Alors oui j'ai demandé à ChatGPT et à Qwen3 (que j'héberge sur une machine dédiée à l'IA). Et evidemment ils m'ont conseillé les rfind, rdfind, dupes, rdupes, rmlint... Mais comparer les hash de 30TB de media, faudrait plusieurs jours, j'ai vite abandonné.

|

||||

Yes, I asked ChatGPT and Qwen3 (which I host on a dedicated AI machine). Naturally, they suggested tools like rfind, rdfind, dupes, rdupes, rmlint... But hashing 30TB of media would take days, so I gave up quickly.

|

||||

|

||||

Au final, je n'ai que des `.mkv` à chercher et les doublons ont exactement les mêmes noms que les originaux, ce qui simplifie grandement la tâche. Un simple script bash devait donc être suffisant.

|

||||

In the end, I only needed to find `.mkv` files, and duplicates have the exact same name as the originals, which simplifies things a lot. A simple Bash script would do the job.

|

||||

|

||||

Je vous passe les incessantes questions réponses avec ChatGPT, je suis assez déçu. Qwen3 a été bien plus propre. ChatGPT n'a pas cessé de mettre des solutions type awk, qui pètent la lecture des chemins au moindre espace. En faisant relire à Qwen, et en lui demandant de se passer de awk, le résultat a été immediatement plus qualitatif.

|

||||

Spare you the endless Q&A with ChatGPT—I was disappointed. Qwen3 was much cleaner. ChatGPT kept pushing awk-based solutions, which fail on paths with spaces. With Qwen’s help and dropping awk, the results improved significantly.

|

||||

|

||||

Pour tester, j'ai d'abord demandé un script qui ne fait que lister et comparer :

|

||||

To test, I first asked for a script that only lists and compares:

|

||||

|

||||

```bash

|

||||

#!/bin/bash

|

||||

|

||||

# Créer un tableau associatif pour stocker les doublons

|

||||

# Create an associative array to store duplicates

|

||||

declare -A seen

|

||||

|

||||

# Trouver tous les fichiers .mkv uniquement (exclure les dossiers)

|

||||

# Find all .mkv files only (exclude directories)

|

||||

find /media/seedbox /media/movies /media/tvseries -type f -name "*.mkv" -print0 | \

|

||||

while IFS= read -r -d '' file; do

|

||||

# Obtenir l'inode du fichier et son chemin

|

||||

# Get the file's inode and name

|

||||

inode=$(stat --format="%i" "$file")

|

||||

filename=$(basename "$file")

|

||||

|

||||

# Si ce nom de fichier a déjà été vu

|

||||

# If the filename has been seen before

|

||||

if [[ -n "${seen[$filename]}" ]]; then

|

||||

# Vérifier si l'inode est différent du précédent

|

||||

# Check if the inode is different from the previous one

|

||||

if [[ "${seen[$filename]}" != "$inode" ]]; then

|

||||

# Ajouter le doublon à la sortie en affichant les chemins complets

|

||||

echo "Doublons pour \"$filename\" :"

|

||||

# Output the duplicates with full paths

|

||||

echo "Duplicates for \"$filename\":"

|

||||

echo "${seen["$filename"]} ${seen["$filename:full_path"]}"

|

||||

echo "$inode $file"

|

||||

echo

|

||||

fi

|

||||

else

|

||||

# Si c'est la première fois qu'on rencontre ce nom de fichier

|

||||

seen[$filename]="$inode"

|

||||

seen["$filename:full_path"]="$file"

|

||||

fi

|

||||

done

|

||||

```

|

||||

|

||||

J'ai ainsi obtenu ce type de réponse :

|

||||

This gave me outputs like:

|

||||

|

||||

```

|

||||

Doublons pour "episode1.mkv" :

|

||||

Duplicates for "episode1.mkv":

|

||||

1234567 /media/seedbox/sonarr/Serie 1/Season1/episode1.mkv

|

||||

2345678 /media/tvseries/Serie 1/Season1/episode1.mkv

|

||||

```

|

||||

|

||||

Avec "awk", il se serait arrêté à `/media/seedbox/sonarr/Serie`. Je ne suis absolument pas un pro, mais Qwen3 a été plus performant et m'a expliqué de A à Z pourquoi et comment faire.

|

||||

With `awk`, it would’ve stopped at `/media/seedbox/sonarr/Serie`. I’m far from an expert, but Qwen3 performed better and explained everything clearly.

|

||||

|

||||

Une fois que j'ai vu que cela fonctionnait bien, j'ai demandé un script qui fait l'intégralité de la cinématique, de la comparaison aux hardlinks en passant par la suppression des doublons.

|

||||

Encore une fois ChatGPT a été décevant. Malgré mes demandes, il créait d'abord les hardlinks et ensuite il supprimait les doublons. Ce qui.. suprimme aussi le lien (meme si cela conserve l'originale). Idiot.

|

||||

Petit détour par Qwen3, et ma RTX 5090 en PLS, et paf un résultat bien plus propre. Bon il a gardé les emoji de ChatGPT qui peut pas s'empecher d'en mettre partout, mais voilà :

|

||||

Once I verified the output, I asked for a complete script: compare, delete duplicates, create hardlinks.

|

||||

|

||||

Again, ChatGPT disappointed. Despite my requests, it created hardlinks *before* deleting the duplicates—effectively linking and then deleting the link (though the original is kept). Not helpful.

|

||||

|

||||

Quick stopover to Qwen3, RTX 5090 in overdrive, and bam—much better result. Yes, it kept ChatGPT-style emojis, but here it is:

|

||||

|

||||

```bash

|

||||

#!/bin/bash

|

||||

|

||||

echo "🔍 Étape 1 : Indexation des fichiers originaux dans /media/seedbox..."

|

||||

echo "🔍 Step 1: Indexing original files in /media/seedbox..."

|

||||

declare -A seen

|

||||

|

||||

# Indexe tous les .mkv dans seedbox

|

||||

# Index all .mkv files in seedbox

|

||||

while IFS= read -r -d '' file; do

|

||||

filename=$(basename "$file")

|

||||

seen["$filename"]="$file"

|

||||

done < <(find /media/seedbox -type f -name "*.mkv" -print0)

|

||||

|

||||

echo "📦 Étape 2 : Remplacement automatique des doublons..."

|

||||

echo "📦 Step 2: Automatically replacing duplicates..."

|

||||

total_doublons=0

|

||||

total_ko_economises=0

|

||||

total_ko_saved=0

|

||||

|

||||

while IFS= read -r -d '' file; do

|

||||

filename=$(basename "$file")

|

||||

@@ -117,30 +118,30 @@ while IFS= read -r -d '' file; do

|

||||

|

||||

if [[ "$inode_orig" != "$inode_dupe" ]]; then

|

||||

size_kb=$(du -k "$file" | cut -f1)

|

||||

echo "🔁 Remplacement :"

|

||||

echo " Doublon : $file"

|

||||

echo "🔁 Replacing:"

|

||||

echo " Duplicate : $file"

|

||||

echo " Original : $original"

|

||||

echo " Taille : ${size_kb} Ko"

|

||||

echo " Size : ${size_kb} KB"

|

||||

|

||||

rm "$file" && ln "$original" "$file" && echo "✅ Hardlink créé."

|

||||

rm "$file" && ln "$original" "$file" && echo "✅ Hardlink created."

|

||||

|

||||

total_doublons=$((total_doublons + 1))

|

||||

total_ko_economises=$((total_ko_economises + size_kb))

|

||||

total_ko_saved=$((total_ko_saved + size_kb))

|

||||

fi

|

||||

fi

|

||||

done < <(find /media/movies /media/tvseries -type f -name "*.mkv" -print0)

|

||||

|

||||

echo ""

|

||||

echo "🧾 Résumé :"

|

||||

echo " 🔗 Doublons remplacés par hardlink : $total_doublons"

|

||||

echo " 💾 Espace disque économisé approximatif : ${total_ko_economises} Ko (~$((total_ko_economises / 1024)) Mo)"

|

||||

echo "✅ Terminé."

|

||||

echo "🧾 Summary:"

|

||||

echo " 🔗 Duplicates replaced by hardlink: $total_doublons"

|

||||

echo " 💾 Approx. disk space saved: ${total_ko_saved} KB (~$((total_ko_saved / 1024)) MB)"

|

||||

echo "✅ Done."

|

||||

```

|

||||

|

||||

Bilan j'ai :

|

||||

- appris pas mal de subtilité bash

|

||||

- appris qu'il ne faut jamais copier coller un script généré ChatGPT sans le comprendre et sans le tester en dry-run

|

||||

- appris que Qwen sur une RTX 5090 est plus cohérent que ChatGPT 4o sur des fermes de serveurs (je vous passe les résultats de la version "normale").

|

||||

- appris que même quand on a 100TB d'espace, monitorer ce dernier m'aurait permis de voir beaucoup plus tot que j'avais 12TB de doublons qui trainent.

|

||||

So, in conclusion, I:

|

||||

- Learned many Bash subtleties

|

||||

- Learned never to blindly copy-paste a ChatGPT script without understanding and dry-running it

|

||||

- Learned that Qwen on a RTX 5090 is more coherent than ChatGPT-4o on server farms (not even mentioning “normal” ChatGPT)

|

||||

- Learned that even with 100TB of storage, monitoring it would’ve alerted me much earlier to the 12TB of duplicates lying around

|

||||

|

||||

A plus tard pour de nouvelles aventures passionnantes.

|

||||

Catch you next time for more exciting adventures.

|

||||

|

||||

@@ -1,69 +1,67 @@

|

||||

---

|

||||

navigation: true

|

||||

title: Scripts python

|

||||

title: Python Scripts

|

||||

main:

|

||||

fluid: false

|

||||

---

|

||||

:ellipsis{left=0px width=40rem top=10rem blur=140px}

|

||||

# Scripts python

|

||||

# Python Scripts

|

||||

|

||||

Mes cochonneries en python

|

||||

My messy Python creations

|

||||

|

||||

## 🤖 Nvidia Stock Bot

|

||||

---

|

||||

|

||||

Depuis déjà 4 ans, la pénurie de materiel electronique fait rage. Et les cartes graphiques ne sont pas épargnées. En 2020, j'ai du attendre 2 mois pour obtenir mon exemplaire de RTX 3080, et pour cela j'ai du m'inscrire sur [JV Hardware](https://discord.gg/gxffg3GA96) où une poignée de geek avait mis en place un bot qui envoyait un ping lorsqu'elles étaient disponibles.

|

||||

For the past four years, the electronics hardware shortage has been relentless. Graphics cards are no exception. In 2020, I had to wait two months to get my RTX 3080. To manage it, I joined [JV Hardware](https://discord.gg/gxffg3GA96), where a small group of geeks had set up a bot that pinged users when GPUs became available.

|

||||

|

||||

4 ans après et 5000 abonnés plus tard, vient la sortie des RTX 5000. Et là aucun bot dispo sur le marché ne semble fonctionner correctement. Je ne parle même pas d'un certain "influenceur" qui se permet de faire payer l'accès à son bot qui ne fonctionne meme pas. Il copie à la main les alertes provenant d'autres serveurs, comme le notre qui ont résolu le problème.

|

||||

Four years later and with 5,000 members on the server, the RTX 5000 series is being released. Yet, no working stock bot seems to exist. Not to mention a certain “influencer” who charges users for access to a bot that doesn’t even work. He manually copies alerts from other servers like ours, which have already solved the issue.

|

||||

|

||||

Quoiqu'il en soit, désireux d'obtenir une RTX 5090 pour ma machine dédiée à l'IA, je me suis dit qu'il était peut etre le temps de plonger dans le monde de python et de ChatGPT pour m'épauler. A l'aide d'un autre membre du serveur, KevOut, qui a principalement guidé sur le principe de départ et les sources des différentes API, j'ai réussi à obtenir un bot propre, fonctionnel, qui envoie différents types d'alertes via Discord. Avec un simple conteneur docker à déployer.

|

||||

Anyway, eager to get an RTX 5090 for my AI-dedicated machine, I decided it was time to dive into Python—with a little help from ChatGPT. Along with another member, KevOut, who helped guide me through the APIs and initial architecture, I ended up building a clean and functional bot that sends different kinds of Discord alerts—all deployable in a simple Docker container.

|

||||

|

||||

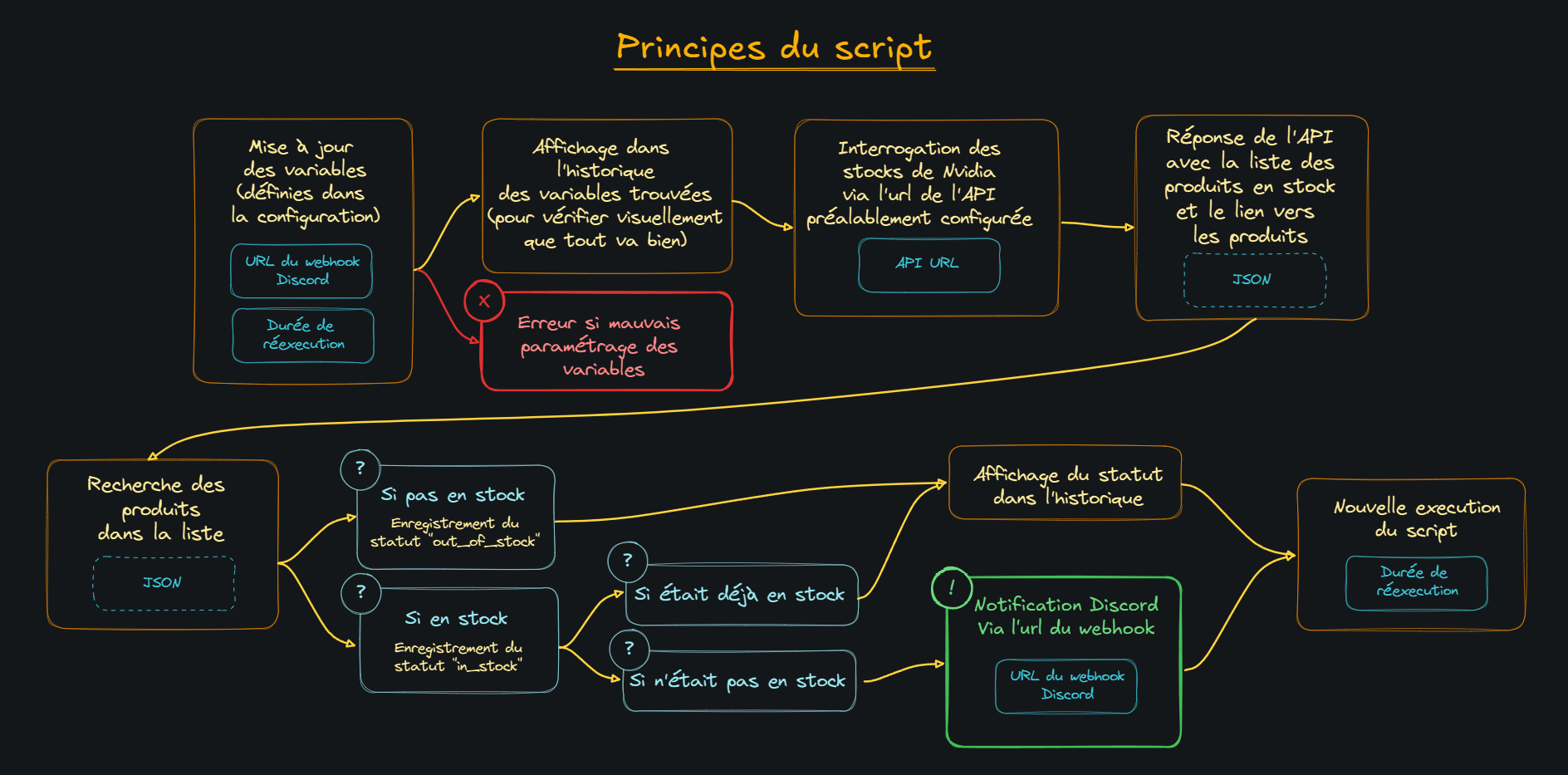

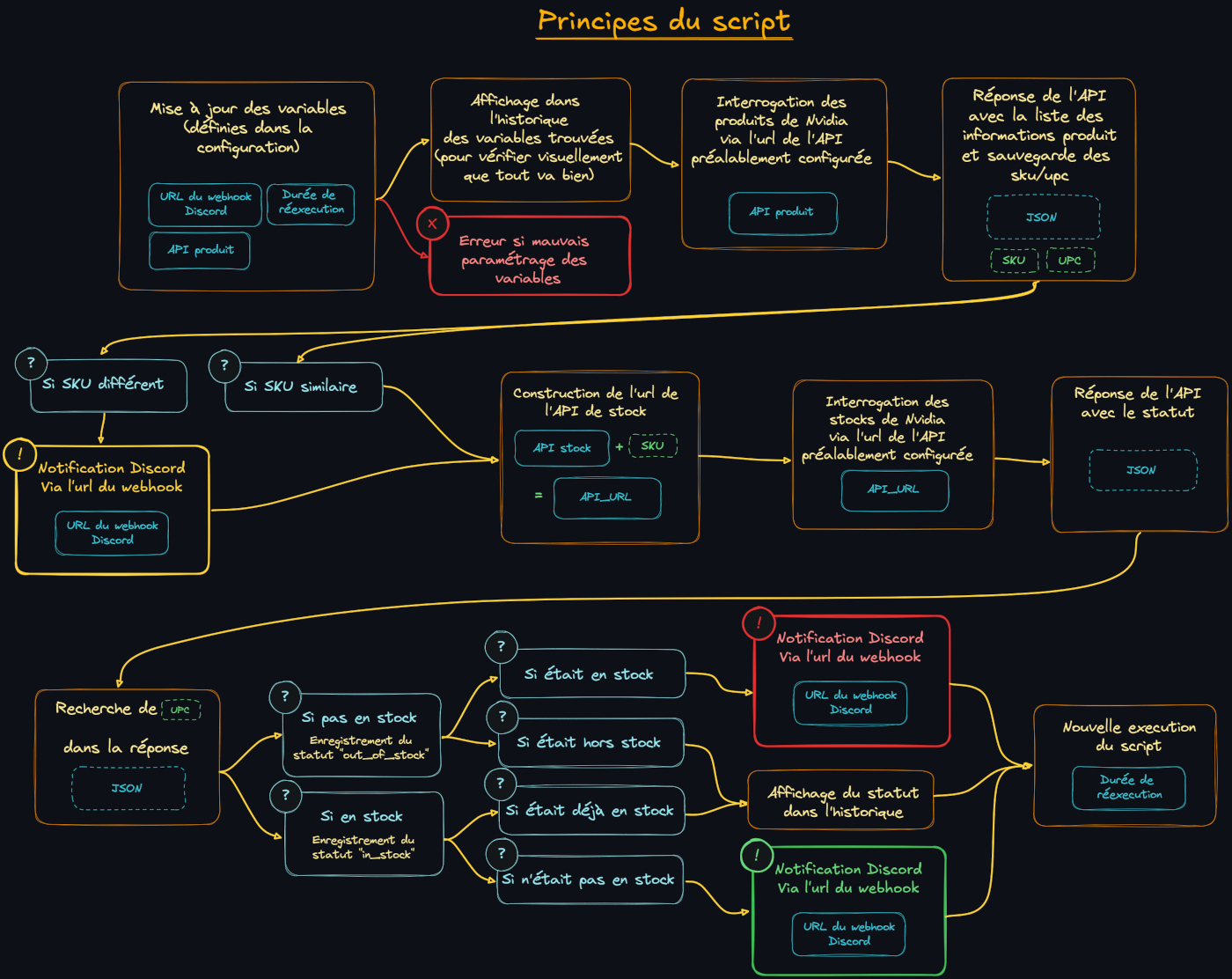

Après moult déconvenues, je suis passé de ceci :

|

||||

After many setbacks, I went from this:

|

||||

|

||||

|

||||

|

||||

à cela :

|

||||

To this:

|

||||

|

||||

|

||||

|

||||

Plus d'infos directement sur le repo :

|

||||

More info directly on the repo:

|

||||

|

||||

|

||||

::card

|

||||

#title

|

||||

🐋 __Nvidia Stock Bot__

|

||||

#description

|

||||

[Robot d'alerte de stock de GPU Nvidia](https://git.djeex.fr/Djeex/nvidia-stock-bot)

|

||||

::

|

||||

::card

|

||||

#title

|

||||

🐋 __Nvidia Stock Bot__

|

||||

#description

|

||||

[Nvidia GPU stock alert bot](https://git.djeex.fr/Djeex/nvidia-stock-bot)

|

||||

::

|

||||

|

||||

## 🤖 Adguard CIDRE Sync

|

||||

---

|

||||

|

||||

Adguard Home est une solution merveilleuse pour filter ses requêtes DNS et ainsi se débarasser de la publicité ou des DNS des fournisseurs d'accès, ou encore réécrire des requetes.

|

||||

Adguard Home is a fantastic solution for DNS-level ad blocking and rewriting requests—perfect for removing ISP DNS trackers or intrusive ads.

|

||||

|

||||

Quand c'est en local, c'est très chouette. Mais quand on veut que tout ses appareils en profitent même à l'exterieur, on est obligé de l'exposer sur le net. Et n'importe qui peut s'en servir et saturer le petit remote à 1€ qu'on a pris pour l'heberger.

|

||||

It works great locally, but if you want all your devices (even on the go) to benefit, you’ll need to expose Adguard to the internet. Unfortunately, that means anyone can use it, potentially overloading your €1/month remote VPS.

|

||||

|

||||

Adguard permet d'avoir des listes de clients autorisés ou bloqués. Problème, pour autoriser un client il faut son IP, et dans le cas d'un téléphone sur le réseau mobile, beh elle change régulièrement. L'idée est donc plutot de bloquer des listes générales plutot que d'autoriser des IP qui de toute façon changent régulièrement.

|

||||

Adguard allows whitelisting or blacklisting clients. The problem? To whitelist a client, you need their IP—but for mobile phones, that IP changes often. Instead of trying to whitelist ever-changing IPs, the better approach is to block broader IP ranges by region.

|

||||

|

||||

CIDRE est un outil qui permet de synchroniser des listes de plages IP géolocalisées mises à jour régulièrement avec un pare feu. Plutot que de faire tourner CIDRE sur le remote complet avec des règles de pare feu complexes, je me suis dit qu'il fallait simplement s'arranger pour ajouter les plages IP à jour que CIDRE propose au systeme de block list d'adguard, selon les pays que l'on souhaite bloquer.

|

||||

CIDRE is a tool that syncs geo-targeted IP ranges with firewalls. Instead of running CIDRE with a full firewall stack on the remote server, I figured I could just import those regularly updated IP ranges into Adguard’s blocklist.

|

||||

|

||||

C'est ainsi qu'est né Adguard CIDRE Sync, un conteneur qui synchronise régulièrement la block list d'Adguard avec les plages IP recensées par CIDRE à la fréquence que vous voulez.

|

||||

Thus, Adguard CIDRE Sync was born: a container that syncs Adguard’s blocklist with CIDRE’s updated IP ranges on a schedule of your choosing.

|

||||

|

||||

L'idée etant de :

|

||||

- Backup le fichier de conf d'Adguard au premier lancement (le fichier jamais touché par le robot est ainsi conservé au cas où)

|

||||

- Télécharger la liste des pays selectionnés via une variable d'environnement

|

||||

- Permettre d'ajouter soi-meme des IP "à la main" dans un fichier

|

||||

- Concaténer le tout, backup le fichier de conf (dernière update), et injecter la liste dans la bonne section du fichier de conf d'Adguard

|

||||

- Recharger Adguard en relançant le container (accès au socket via docker socket proxy pour limiter les permissions)

|

||||

The idea is to:

|

||||

- Backup Adguard’s config file on first run (original untouched version saved)

|

||||

- Download selected country IP ranges via an environment variable

|

||||

- Let you manually add custom IPs via a file

|

||||

- Concatenate, backup the config again (as the updated version), and inject the list into the correct blocklist section

|

||||

- Reload Adguard by restarting the container (using Docker socket proxy for limited permissions)

|

||||

|

||||

Tout ceci de manière complètement autonome, avec une fréquence choisie en variable d'environnement dans la conf du compose.

|

||||

All fully autonomous, with frequency set via environment variable in the `docker-compose` config.

|

||||

|

||||

Plus d'infos directement sur le repo :

|

||||

More info directly on the repo:

|

||||

|

||||

|

||||

::card

|

||||

#title

|

||||

🐋 __Adguard CIDRE Sync__

|

||||

#description

|

||||

[Robot de synchronisation de la blocklist d'Adguard](https://git.djeex.fr/Djeex/adguard-cidre)

|

||||

::

|

||||

::card

|

||||

#title

|

||||

🐋 __Adguard CIDRE Sync__

|

||||

#description

|

||||

[Adguard blocklist sync bot](https://git.djeex.fr/Djeex/adguard-cidre)

|

||||

::

|

||||

@@ -1,2 +1,2 @@

|

||||

icon: noto:test-tube

|

||||

navigation.title: Mes bêtises

|

||||

navigation.title: My nonsense

|

||||

|

||||

Reference in New Issue

Block a user